Die Big Data Conference Europe hatte 2020 zahlreiche internationale und hochkarätige Speaker zu bieten, die allesamt spannende Bereiche beleuchtet haben. Die Reise nach Vilnius in Litauen fiel zwar leider aus, aber die Konferenz fand als virtuelle Ausgabe statt. Und ich hatte zum zweiten Mal in Folge das Vergnügen, als Sprecher dabei zu sein.

Das Thema meines Vortrags war der Einsatz von Cloud-Diensten in Daten-Workflows und Pipelines innerhalb der eigenen Infrastruktur. Cloud-Dienste können bei datengetriebenen Projekten und besonders im Umfeld von Machine Learning einige klassische Herausforderungen auflösen oder zumindest abmildern.

Mangel an Talenten

Die Ansprüche an die Talente von Mitarbeitern für datengetriebene Projekte aller Art sind hoch. Das Skillset, das heutzutage dafür benötigt wird, ist umfangreich. Grundsätzliche ETL Skills sind hierbei die kleinste Hürde. Data Scientists müssen ein tiefes Verständnis von Daten aufbringen. Bei der Arbeit mit natürlicher Sprache sind Kenntnisse im Natural Language Processing Bereich notwendig. Und wenn es in Richtung von Machine Learning geht, kommen Kenntnisse in Feature Engineering und den entsprechenden Algorithmen noch hinzu.

Mangel an Daten

Die nächste Herausforderung ist der Mangel an Daten. Grundsätzlich an Daten zu kommen, ist heutzutage kein Problem. Gerade im Fall von Supervised Learning geht es aber nicht darum, überhaupt Daten zu haben, sondern entsprechend gekennzeichnete Daten zu haben. Wer zum Beispiel ein Modell zum Erkennen von Entitäten mit Apache OpenNLP trainieren möchte, braucht 15.000 Sätze mit entsprechender Auszeichnung der Entitäten. Eine Hürde, die üblicherweise nur mit Fleiß und Arbeit zu überwinden ist.

Mangel an Ressourcen

Sind die richtigen Daten mit entsprechender Auszeichnung vorhanden, geht es an das Trainieren von Modellen. Doch Modelle zu trainieren, zu evaluieren und zu tunen sind Arbeitsschritte, die durchaus Zeit in Anspruch nehmen können und – je nach Szenario – viel Hardware benötigen. Die Hardware einfach anzuschaffen, verschiebt aber diese Herausforderung nur. Denn sind die Modelle trainiert und werden nicht regelmäßig neue Modelle trainiert, dann wird die Hardware nicht wirklich ausgelastet und steht ungenutzt im Rechenzentrum – nicht optimal!

Cloud-Dienste als Lösung?

Der Einsatz von Cloud-Diensten bietet bezüglich dieser Herausforderungen klare Chancen. Für den Einsatz von Cloud-Diensten brauche ich nicht unbedingt Spezialisten, denn in vielen Fällen bedeutet deren Nutzung das Aufrufen von APIs. Eigene Modelle müssen nicht trainiert werden, sondern sie wurden bereits trainiert; und ich nutze sie, indem ich die Cloud-Dienste nutze. Zusätzliche Hardware wird auch nicht mehr benötigt: Bei Cloud-Diensten erfolgt die Abrechnung nach Nutzung. Untätige und nicht ausgelastete Hardware wird dadurch ausgeschlossen.

Doch wie so oft hat auch diese Medaille zwei Seiten. Schneller am Markt zu sein, weniger Know-how zu benötigen oder aufbauen zu müssen und nur anhand der eigenen Nutzung zur Kasse gebeten zu werden, kann – je nach Szenario – schnell durch Nachteile aufgewogen werden:

• Generische Modelle in den Cloud-Diensten sind schlecht anwendbar auf domänenspezifische Herausforderungen.

• Sie haben in der Regel nur wenig Möglichkeiten der Steuerung und Kontrolle

• Starke Nutzung eines solchen Dienstes kann zu hohen Kosten führen.

Es gibt also einiges abzuwägen, wenn es um den Einsatz von Cloud-Diensten geht. Das gilt im Bereich der Künstlichen Intelligenz (KI) genauso wie in anderen Bereichen.

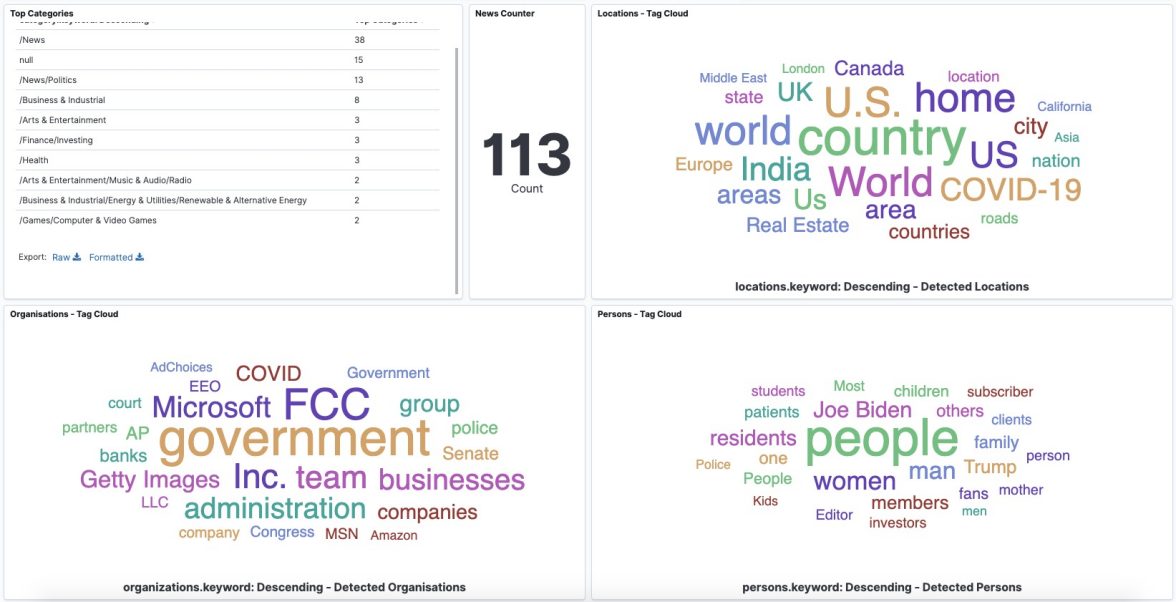

Anhand eines konkreten Beispiels habe ich im Rahmen meiner Präsentation die Nutzung eines Dienstes näher beleuchtet. Das Erkennen und Extrahieren von Entitäten mittels der Natural Language API der Google Cloud Platform. Mit den Open Source Komponenten NiFi, Elasticsearch & Kibana war der Prototyp schnell gebaut, und so las NiFi Nachrichten von der API des GDELT-Projekts, transformierte diese Nachrichten, schickte den Text an die Natural Language API, extrahierte die Entitäten aus der Antwort, um den Text samt erkannter Entitäten an Elasticsearch zu schicken. Ein simples Kibana-Dashboard ermöglichte eine erste Datenexploration, die selbst in diesem äußerst eng abgesteckten Demo-Rahmen schon Beziehungen zwischen Entitäten erkennen ließ.

Big Data Conference Europe: das virtuelle Format

Bereits 2019 war die Big Data Conference Europe hervorragend organisiert, und so war es dieses Jahr auch. Die Veranstalter, Organisatoren und das Technik-Team haben es mir im Vorfeld einfach gemacht, die Inhalte im virtuellen Format zu präsentieren. Grundsätzlich fehlt es meiner persönlichen Ansicht nach virtuellen Formaten an Austauschmöglichkeiten zwischen Speakern, Teilnehmern, Veranstaltern und Sponsoren. Dennoch muss ich sagen: Lieber eine virtuelle Konferenz als keine Konferenz. Nächstes Jahr gerne wieder, und dann hoffentlich wieder in Litauen!

Elasticsearch and Kibana are trademarks of Elasticsearch BV, registered in the U.S. and in other countries.